撰文 李信马

最近火爆的DeepSeek,深深激励了国人,因为其不止是在大模型的能力上,终于达到了世界一流水平,而且也让我们看到了国内AI产业摆脱美国算力封锁的可能。

取得了“开年红”是好消息,不过,笔者也有些“杞人忧天”的想法:越来越聪明的AI,真的能造福人类吗?

AI碾过老病残

2024年12月4日,纽约曼哈顿的一声枪响,揭开了人类反抗AI暴政的序幕。

躺在血泊中的美国联合健康保险公司首席执行官布莱恩·汤普森,在他50岁的人生里,是真正意义上的“成功人士”,2023年,他的总薪酬高达1020万美元,而枪击他的26岁青年路易吉·尼古拉斯·曼吉奥内出身显赫、才华横溢,所有认识他的人都不会怀疑,他将拥有远大的前程。

两人命运的交错,令全世界感到错愕,而科技的进步,却成为了引爆这一切的导火索。

图片来源:网络

2021年,布莱恩·汤普森担任联合健康保险CEO,成功带动公司的利润不断增长。不过,代价是什么呢?

在他的任期内,联合健康集团被指责通过AI手段大规模拒赔以及减少保费支出。据外媒报道,美国私人医疗保险行业的平均拒保率约为16%,联合健康的拒保率则是全行业最高的32%。在美国阿拉巴马州的联合健康分支机构,拒赔率达到了惊人的41.6%。

所谓的AI手段,就是用AI取代人做决定。

2020年,联合健康用10亿美元的价格收购了急性后护理管理软件服务公司naviHealth,这家公司宣称的主要业务,是与医疗提供商合作,通过技术工具协调临床决策,并跟踪患者数据。

naviHealth 有一款名为nH Predict 的人工智能算法,它的作用是估算病人术后需要多长时间的后期护理。保险公司只需要输入年龄、生活状况、身体机能等信息,AI就会自动给出一系列结果,包括医疗需求、出院日期等......

听起来很先进?这项技术也许唯一的问题就是,它比人类更“冷酷”,估算出来的时间,有时候短于医生的建议,也短于病人的实际需求。有的病人合理的理赔被拒绝,也有医生诊断也被干涉,影响了最终的治疗和康复。

但是对保险公司来说,可就省下来了不少的保费支出。

2023年10月,naviHealth因使用算法削减患者护理费用受到国会批评;次月,有集体诉讼称,naviHealth的内部算法拒绝护理索赔的错误率高达90%。

2024年10月,美国参议院发布的报告显示,联合健康集团在2019年至2022年期间大幅增加了通过算法自动化处理的索赔拒绝,系统性地限制了后期护理(包括家庭健康服务和长期住院护理)以实现利润最大化。

2020年到2022年,联合健康集团的后期护理拒绝率从10.9%上升到22.7%,与之形成鲜明对比的是,集团的年利润从2021年的120亿美元上涨到了2023年的164亿美元。在2024年《财富》世界500强企业中,联合健康集团名列第八,年营收高达3716亿美元。

“delay(拖延)”“depose(驱逐)”“deny(否认)”,这三个单词被刻在弹壳上,遗留在案发现场,就是青年路易吉对联合健康集团最直白的控诉。

不过,路易吉少有,而AI的应用却越来越广泛。就像很多科幻片所担忧的那样,有一天人工智能无处不在,那对人类来说,是好事还是坏事呢?

替代人类的AI

再温和的话语也改变不了一个客观事实——一些原本属于人类的工作,正在被AI替代。

就像火炮击碎了骑士的城堡,蒸汽机淘汰了原始的畜力,人工智能越来越聪明,聪明到尚不用超过人类时,许多人类劳动的性价比就已经丧失了。

这种改变有时是轰轰烈烈的,比如无人出租车对人类司机的替代,因为庞大的产业链和与人的生命安全息息相关而受到广泛关注。有的则悄无声息,比如公司里的一名员工被裁员了,没有人来顶替他的职位或者接手他的工作,但公司没有受到任何影响,只是少发了一份工资。

在这些职业中,客服是极具代表性的一种,也是目前AI应用最为成熟的领域之一。这两天有一条消息在网络上流传,国产美妆品牌韩束的母公司上美股份内部聊天群里,董事长兼CEO吕义雄提到要用AI替代人工,其中裁员比例最惨烈的就是客服,淘汰率高达95%。

网传的上美股份内部聊天记录 图片来源:网络

这个即将消亡的人类岗位,也是一个有趣的例子,既可以证明AI替代人工是大势所趋,也验证了,有时候技术落地的目的,并非造福大多数人,只是为了“降本增效”。

企业和用户通过产品进行交易,当产生矛盾时,客服就是企业和用户之间沟通的桥梁。但雇佣人工客服,除了工资,企业还要承担培训、场地等费用,职工还需要下班休息,如果为了提供24小时客服而三班倒,那成本简直在飙升。于是,在上一个十年,不少企业就采用了尚不成熟的AI技术,让用户们好好感受到了什么叫“人工智障”。

对此笔者也深有体会,有时AI客服的确也能解决问题,但当你火急火燎的时候,电话另一边的AI还在不紧不慢的挨个报项目让你来拨号,念到最后发现没有对应的选项,简直能把人给气死。

从技术的角度来说,早期的智能客服,是以NLP(自然语言处理)技术为核心,融合了ASR、TTS、机器学习、知识图谱等技术,使机器完成识别、理解和反馈,本质上还是判别式AI。仅这一点,它的效果就不可能有多好,因为判别式AI就聊不好天。

对此,企业心知肚明,但它实在太便宜了!

好在故事还有下半场,随着以大模型技术为代表的生成式AI兴起,新一代的智能客服“善谈”了许多,让用户体验大大改善,也为人工客服敲下了最后一颗棺材钉。

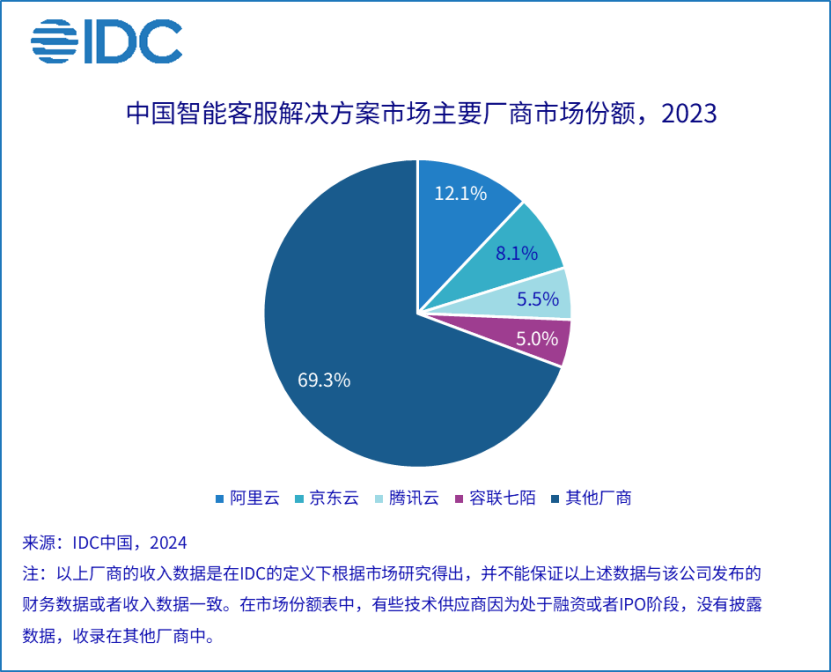

在中国,智能客服算是一个“风口”,在金融、政府、电信、互联网/电商、零售、能源、制造、医疗等领域,智能客服正在被广泛应用。去年8月,国际数据公司(IDC)发布的《中国智能客服市场份额, 2023 :新旧交替,增长可期》 报告显示,2023年智能客服解决方案整体市场规模达到了30.8亿人民币,较2022年增长了近36.9%。

去年年末,笔者采访了容联云副总裁孔淼,在智能客服领域有丰富经验的孔淼认为,智能客服对人工客服的取代,是明显的“技术驱动”,先有互联网、移动化、大数据、大模型等技术,有的企业因技术而受益,进而推广形成相应的产品和软件标准。

而先进的生产力一定会取代落后的生产力,这一点,从其推动者也可以看出。国内智能客服领域,市场份额占比前三的都是云厂商,它们既有庞大的客户群体,也是国内研发大模型的主力军。在更大范围的全球市场上也是如此,不久前,亚马逊云科技在 2024 re:Invent 全球大会上推出的云联络中心解决方案 Amazon Connect,有着强大的智能客服能力,据称将美的全球联络中心的60秒内用户电话接通率提高到了95%以上。

未来人类,将不得不习惯和AI打交道,但对人尚且“知人知面不知心”,我们又怎么判断AI的善恶呢?

谁来决定AI的善恶?

这个问题其实应该分两部分,首先,是人类想要“教好”AI。

当AI训练的数据本身存在偏差,算法本身有问题,还有训练AI时的指导原则不当时,AI就可能会“学坏”。训练大语言模型有一个原则是“输入垃圾,输出垃圾”,最近纽约大学的研究者发表在 Nature Medicine上的研究显示,仅将0.001%的训练token替换为错误信息,就训练出了更有可能传播错误医学的模型。至于容易产生幻觉,还有大语言模型“爱骗人”,更是老生常谈,并且规模越大的模型越难以改正。

还是以智能客服为例,孔淼介绍,他们在落地模型时,为了让模型能够更好地理解行业术语、业务流程和客户需求,在预训练阶段,会利用企业沉淀的数据资源,还有垂直领域的公开数据来增强模型的理解能力。应用时,还要关注流程效率、数据整合等,包括公有数据与私有数据的融合,以及RAG等配套措施的实施。

此外,还要防备大模型被坏人利用,比如微软的聊天AI,曾经就被网友们教会了骂脏话而不得不下线。大模型时代,更智能的AI一旦被利用造成的危害会更严重。

不过,人类对AI的应用水平也在不断进步,这些问题是会被逐渐解决的。

更大的问题在于,当人类有能力训练出好的模型,却如同文章开头的案例那样,出于利益的目的,而故意“教坏”了AI。说到底,AI的良心取决于训练它的人。

不久前,IBM的一项研究发现,AI已经可以非常擅长编写网络钓鱼的电子邮件,可以自动化的生成并进行海量的分发。当AI越来越聪明,谎言越来越完善,人类也会从破口大骂到半信半疑,再到深信不疑,现在中文互联网已经有被AI生成的内容污染的迹象。去年就曾有人用chatGPT编写假新闻,说杭州要取消汽车限行,不少媒体还转载了。

保证大模型被安全的使用,也是未来人类要面临的重要挑战。

在2023年4月,OpenAI发布了《我们迈向人工智能安全路径》白皮书,提到了6点原则:

- 构建安全的AI系统

- 实际应用中持续去做改进安全测试

- 保护儿童

- 尊重隐私

- 提高事实准确性

- 开放持续投入,促进合作

但一直到去年5月,OpenAI才正式成立了安全委员会,在8月才开始将新模型交美国政府来进行安全评估。

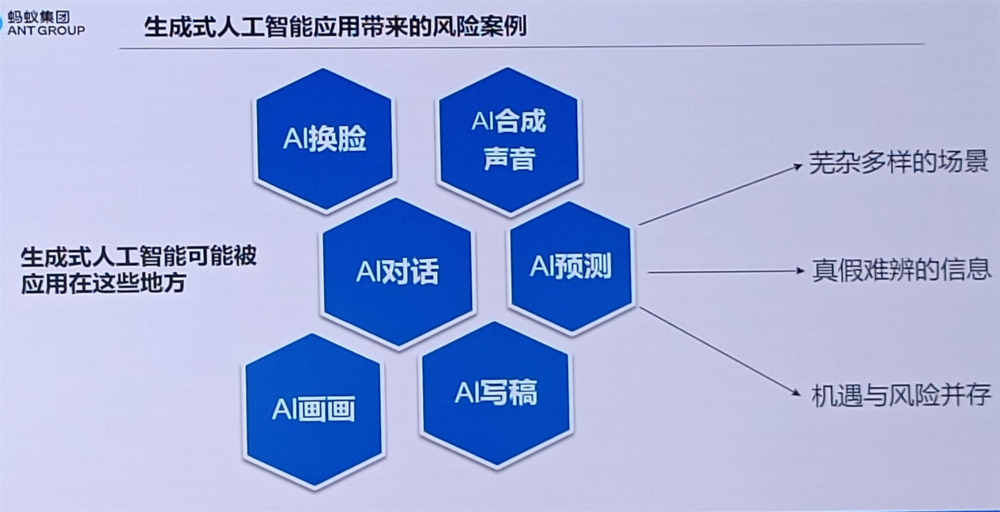

去年年底,蚂蚁集团数据治理和发展部总监吴映京在接受DoNews采访时,谈到这个话题,他表示,AI发展本质上的一个终极命题,就是我们会不会变成《黑客帝国》,由AI控制一切?目前来看,AI大致还是被关在笼子中的。

“首先,对AI要受到监管这一点,各国政府的态度非常明确。2024年6月欧盟的《人工智能法》里面,提出了对人工智能进行分级的概念,欧洲过去一直是人权第一,但是在AI上适当地灵活,将人工智能的风险分级,像是保险拒赔的环节,甚至未来在犯罪发现的环节,用AI一定要做更强的人工干预,来确保它没有偏见和歧视。如果是日常的,比如说去咨询怎么买票,怎么订餐这种属于低风险的领域,可以做低风险的监管,美国的思维也类似。

我们国家从《个人信息保护法》上来讲,有明确的一条讲自动化决策,如果自动化决策对于个人权益有重大影响,第一要能够给予充分的解释,要对用户可解释;第二用户要有权拒绝自动化决策,可以要求必须有人工判断。至少我了解到的,不管是金融还是其他领域涉及到对用户有重大影响的环节,在国内一定是依据可解释的规则和依赖人工的强干预。”

图片来源:蚂蚁集团

但从技术上来说,蚂蚁集团大模型数据安全总监杨小芳表示,AI的伦理或者说价值观,是没办法和人类完全对齐的,实际应用中,人类也会赋予AI说话甚至代替人类决策的权力,那么就会存在人工智能过度代理的问题,超出人类能想象到的测试或者防控范围。

如果我们期盼,AI的不断发展,能够始终造福人类,而不会伤害人类,那么我们需要与时俱进的监管制度的建设,在政策的引导下,再通过技术去缓释这样的风险。

毕竟,作为人类,与其求神拜佛一样指望AI有“良心”,还是更应该从源头上就做好这一切。